در این جلسه، به مرور آنچه در پروژهی عملی نخست انجام دادیم میپردازیم و بر اساس همان تجربه، دربارهی فرایند EDA (تحلیل اکتشافی دادهها) و چالشهای رایج در آن بحث میکنیم.

در پروژهی قبلی، گامبهگام با کمک ابزارهای اجرایی و کدنویسی پیش رفتیم. کدها را اجرا کردیم، خروجیها را مشاهده نمودیم و در نهایت پروژهی EDA را تا حد مناسبی پیش بردیم. حال در این ویدیو قصد داریم نه صرفاً محدود به همان پروژه، بلکه بر پایهی آن، دربارهی کارهایی که در فرایند EDA انجام میشود و چالشهایی که معمولاً با آنها مواجه هستیم صحبت کنیم.

چالش نخست: دسترسی به منابع داده

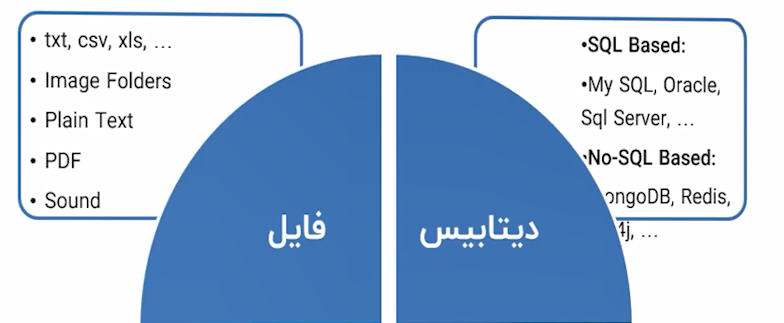

یکی از مهمترین مسائل در شروع هر پروژه، دسترسی به منابع داده است. در پروژهی آموزشی، ما یک فایل CSV (بهعنوان دادهی تخت یا Flat File) داشتیم، آن را ایمپورت کرده و کار خود را آغاز کردیم. اما در پروژههای واقعی، وضعیت پیچیدهتر است و با سناریوهای متعددی روبهرو میشویم:

۱. فایلها

دادهها ممکن است در قالب فایلهای مختلفی ذخیره شده باشند.

-

فرمتهای متداول مانند CSV یا TXT.

-

فایلهای متنی شامل ایمیلها، مقالات، رمانها یا کامنتهای کاربران در شبکههای اجتماعی.

-

فایلهای PDF یا حتی فایلهای صوتی.

-

دادههای تصویری (تصاویر ذخیرهشده در پوشهها).

هر یک از این انواع، ابزارها و دستورات خاص خود را برای واکشی و پردازش نیاز دارد.

۲. پایگاههای داده (Databases)

در پروژههای سازمانی، دادهها عموماً در پایگاههای داده ذخیره میشوند.

-

پایگاههای دادهی رابطهای (SQL-based) مانند MySQL، Oracle، SQL Server، PostgreSQL.

-

پایگاههای دادهی غیررابطهای (NoSQL) مانند MongoDB، Redis یا پایگاههای گرافی مانند Neo4j.

آشنایی با زبان SQL برای واکشی دادهها ضروری است. البته نیازی به تخصص عمیق در یک نرمافزار خاص مانند Oracle وجود ندارد؛ دانستن مفاهیم و توانایی کوئرینویسی کفایت میکند. تغییرات جزئی در سینتکس را میتوان بهسرعت از مستندات هر سیستم یاد گرفت.

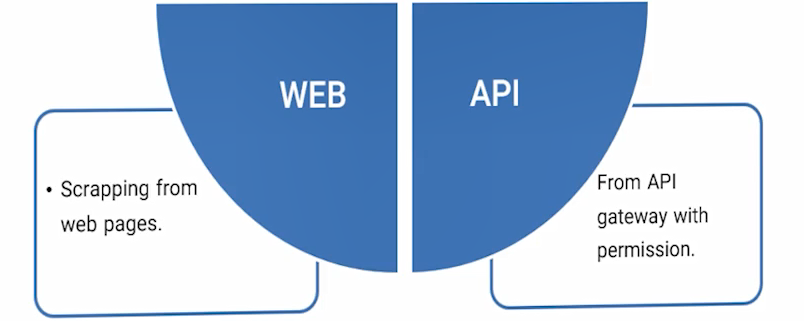

۳. APIها

APIها درگاههایی هستند که امکان دسترسی به دادههای یک سرویس را فراهم میکنند. بسیاری از وبسایتها و سرویسها دادههای خود را از طریق API در اختیار توسعهدهندگان قرار میدهند. به عنوان مثال:

-

دریافت اطلاعات آبوهوا از سرویسهای گوگل.

-

واکشی دادههای مالی از سرویسهای فایننس.

APIها نقش واسطه میان نرمافزارها را ایفا میکنند و یادگیری استفاده از آنها برای یک دانشمند داده ضروری است.

۴. دادههای وب (Web Scraping)

گاهی لازم است دادهها را مستقیماً از صفحات وب استخراج کنیم. این کار با استفاده از خزندهها و کتابخانههای تخصصی انجام میشود. دادهها پس از جمعآوری میتوانند در فایلها یا پایگاههای داده ذخیره شوند.

نتیجه: اگر نتوانیم به داده دسترسی پیدا کنیم، پروژه در همان ابتدا متوقف میشود. بنابراین تسلط بر روشهای مختلف واکشی دادهها (از فایلها، پایگاههای داده، APIها و وب) اهمیت بنیادین دارد.

مرور اقدامات انجامشده در پروژهی EDA

در پروژهی آموزشی گذشته، فعالیتهای زیر انجام شد:

-

بررسی اولیه دادهها: مشاهدهی ساختار جدولی دادهها.

-

خلاصهسازی آماری: محاسبه و بررسی آمار توصیفی.

-

بصریسازی دادهها: رسم نمودارهای مختلف برای درک بهتر توزیعها و روابط.

-

ارتباطسنجی متغیرها: بررسی ارتباط جنسیت، سن، کلسترول، فشار خون و سایر ویژگیها با نوع داروی تجویزی.

-

به عنوان مثال، مشخص شد که جنسیت اثر معناداری بر نوع داروی تجویزی ندارد.

-

در مقابل، سن و کلسترول تفاوتهای قابل توجهی در ارتباط با دارو نشان دادند.

-

-

کیفیت دادهها:

-

شناسایی مقادیر گمشده (Missing Values).

-

بررسی دادههای پرت (Outliers).

-

نقش آمار و احتمال در EDA

همانطور که در جلسات پیشین اشاره شد، آمار و احتمال نقش کلیدی در علم داده دارند. در پروژهی انجامشده بهتر متوجه شدیم که مفاهیمی چون خلاصهسازی و ارتباطسنجی دقیقاً چه معنا و کاربردی دارند.

-

خلاصهسازی آماری: ارائهی شاخصهایی که وضعیت کلی دادهها را نشان میدهند.

-

ارتباطسنجی: بررسی اثرگذاری یا وابستگی میان ویژگیها.

-

بصریسازی: نمایش دادهها بهصورت نمودار برای درک شهودی بهتر.

این سه بخش، در کنار مباحث تئوری احتمال، پایههای اصلی تحلیل اکتشافی دادهها را تشکیل میدهند.

ادامه مسیر

در ویدیوهای بعدی، با استفاده از همین پروژه بهعنوان مطالعهی موردی، مباحث زیر را دقیقتر بررسی خواهیم کرد:

-

تعاریف دقیقتر در تئوری احتمال.

-

کاربردهای آمار و احتمال در پروژههای دادهمحور.

-

ارتباط مستقیم این مفاهیم با تسکهای EDA (خلاصهسازی، ارتباطسنجی و بصریسازی).

هدف این است که ضمن مرور تئوریها، بتوانیم آنها را در پروژههای عملی بهکار ببریم و از سطح مشاهدهی شهودی به سمت تحلیل علمیتر حرکت کنیم.

بدین ترتیب، در این جلسه علاوه بر مرور پروژهی عملی، چالشهای اصلی در دسترسی به دادهها و نیز نقش آمار و احتمال در EDA مورد بحث قرار گرفت. این موضوعات پایهای، راه را برای مباحث تئوریک و عملی پیشرفتهتر در جلسات آینده هموار میکنند.